Quando si parla di Intelligenza Artificiale, la nostra immaginazione tende spesso a volare verso software sofisticati capaci di apprendere e decidere autonomamente.

Queste concezioni sono intrinsecamente affascinanti e sembrano catapultarci direttamente in un futuro tecnologico.

Nonostante l’enfasi prevalente sul software, un aspetto cruciale di frequente trascurato è l’hardware.

I componenti fisici dei computer, infatti, non sono meri contenitori passivi, ma rappresentano il fulcro indispensabile che consente all’IA di operare efficacemente.

Questi elementi costituiscono il pilastro su cui si ergono tutte le tecnologie avanzate di Intelligenza Artificiale.

Il ruolo dell’hardware può essere paragonato al motore di un’automobile: senza un propulsore adeguatamente potente, non importa quanto avanzata sia la tecnologia che la governa, l’auto non sarà in grado di performare al meglio.

Allo stesso modo, senza una potenza di calcolo sufficiente, i modelli di IA non possono processare grandi volumi di dati né apprendere con efficacia.

Questa realtà si riflette nella comune esperienza di provare a eseguire software moderno su computer datati: indipendentemente dall’avanzamento del software, se l’hardware non è all’altezza, il sistema risulterà lento e potrebbe persino fallire nel suo compito.

Hardware per l’IA: fondamenti

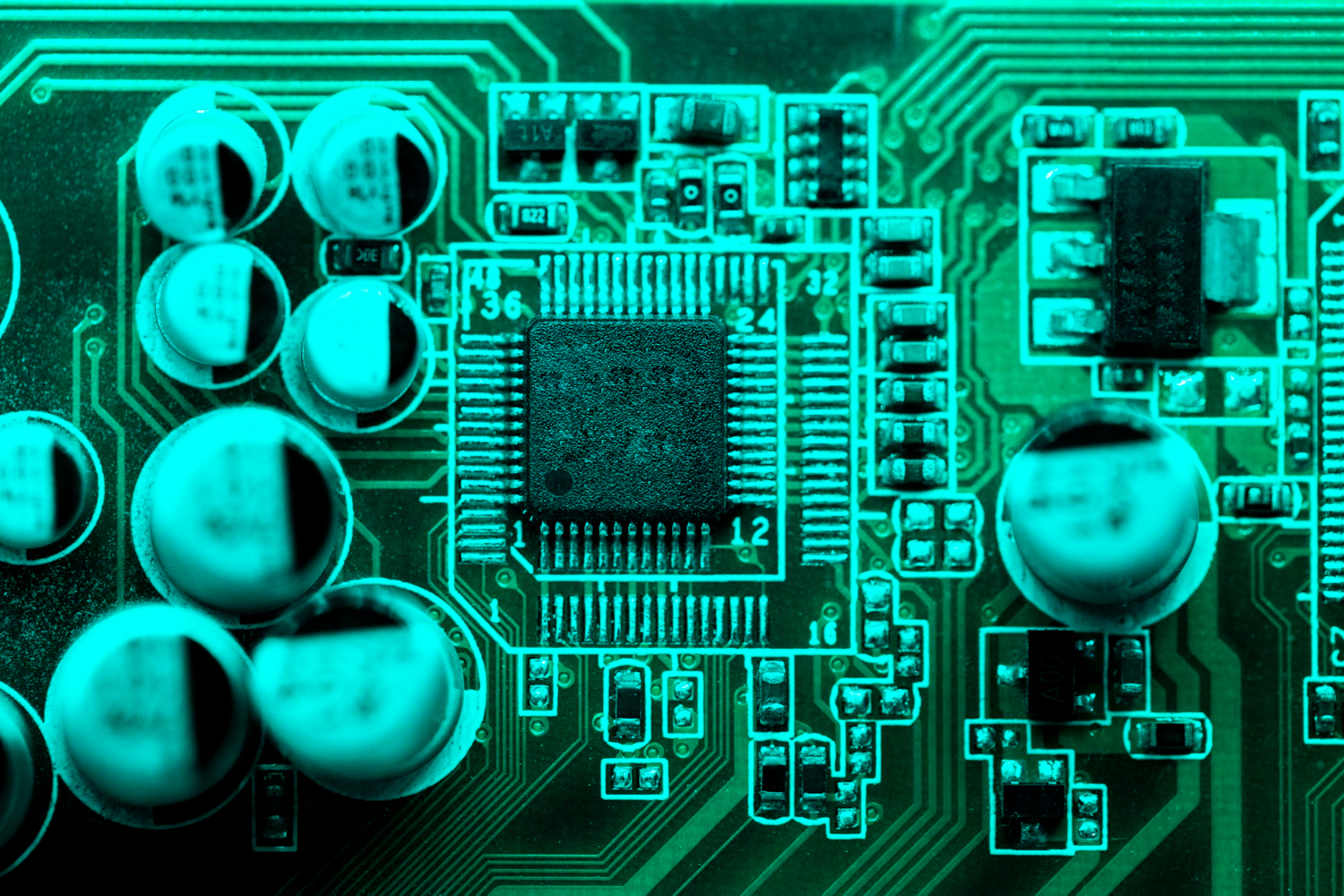

Per capire come l’hardware influisce su sistemi di Intelligenza Artificiale, è importante conoscere i componenti principali coinvolti.

Tra questi, i più significativi sono le CPU (Central Processing Unit), le GPU (Graphics Processing Unit), le TPU (Tensor Processing Unit) e le FPGA (Field Programmable Gate Array), ed ognuno di questi ha un ruolo specifico e importante nel mondo dell’IA.

CPU

La CPU è il cervello del computer, incaricata di eseguire i programmi.

Nell’IA, è fondamentale per gestire le operazioni di routine e i compiti meno esigenti dal punto di vista del calcolo.

Nonostante non sia la più veloce nel processare algoritmi complessi, le CPU sono versatili e indispensabili per l’esecuzione di codici che non richiedono un’intensa capacità di calcolo parallelo, come quella necessaria per le reti neurali.

GPU

Le GPU sono ottimizzate per gestire molti compiti contemporaneamente, rendendole ideali per i modelli di deep learning che necessitano di grandi quantità di calcoli matematici simultanei.

Originariamente sviluppate per migliorare la grafica nei videogiochi, le GPU sono ora essenziali per velocizzare il training dei modelli di IA, tagliando drasticamente i tempi necessari.

TPU

Le TPU, sviluppate da Google specificamente per il machine learning, offrono prestazioni elevate in compiti specifici, soprattutto nel deep learning.

Questi chip sono specializzati nell’eseguire rapidamente operazioni matriciali, cruciali in molte architetture di apprendimento automatico, e possono significativamente accelerare l’apprendimento e l’inferenza nelle reti neurali.

FPGA

Le FPGA sono chip che possono essere configurati dopo la produzione per svolgere compiti specifici.

Nell’IA, sono valorizzate per la loro flessibilità e la capacità di adattarsi a specifici algoritmi, offrendo un compromesso tra un hardware personalizzato e uno generico.

Sono particolarmente utili in applicazioni in cui i requisiti possono cambiare nel tempo o dove l’efficienza energetica è cruciale.

Ogni tipo di hardware ha un impatto diretto sulle prestazioni dei modelli.

La scelta dell’hardware giusto dipende dal tipo di applicazione, dalla scala del progetto e dalla velocità richiesta.

Ad esempio, per compiti che necessitano una grande interazione in tempo reale o l’elaborazione rapida di grandi quantità di dati, GPU e TPU sono generalmente preferite.

Per progetti meno intensivi, una CPU può bastare.

Le FPGA, invece, sono ideali per situazioni che richiedono una personalizzazione estrema o dove l’efficienza energetica è fondamentale.

Capire le funzioni e le limitazioni di ogni tipo di hardware è essenziale per ottimizzare le prestazioni dei modelli di IA e utilizzare le risorse nel modo più efficiente.

Hardware per l’IA: criteri di scelta

Scegliere l’hardware giusto per i progetti di Intelligenza Artificiale è essenziale e dipende da vari fattori come prestazione, efficienza energetica, costo e scalabilità.

Vediamoli qui di seguito.

Prestazione: velocità di calcolo e capacità di parallelismo

La prestazione è fondamentale nella scelta dell’hardware per l’IA.

La velocità di calcolo misura quanto rapidamente un dispositivo può processare i dati.

Nei casi in cui sono necessari milioni di calcoli, una maggiore velocità di calcolo permette di ottenere modelli più rapidi e precisi.

Il parallelismo, ovvero la capacità di effettuare molti calcoli contemporaneamente, è cruciale per il training di modelli di deep learning.

GPU e TPU sono particolarmente vantaggiose in questo ambito, grazie alla loro capacità di gestire calcoli paralleli, accelerando significativamente il processo rispetto alle CPU tradizionali.

Efficienza energetica: un pilastro per il funzionamento sostenibile

L’efficienza energetica è vitale, specialmente in un’era dove la sostenibilità è prioritaria.

I data center dedicati all’apprendimento automatico consumano grandi quantità di energia, quindi un hardware efficiente può ridurre l’impatto ambientale e i costi operativi.

FPGA e alcune GPU recenti sono progettate per massimizzare l’efficienza energetica, bilanciando prestazioni e consumo di energia.

Costo: bilanciare budget e prestazioni

Il costo è sempre un fattore chiave, sia per le startup che per le aziende consolidate.

L’investimento iniziale in hardware può essere sostanziale, ma è cruciale valutare il rapporto costo-beneficio.

Hardware più costoso, come le GPU di fascia alta o le TPU, può garantire prestazioni superiori, ma è importante assicurarsi che tali prestazioni siano necessarie per le applicazioni previste.

A volte, una combinazione di CPU e GPU può essere una soluzione più economica e adeguata, specialmente per progetti in fase iniziale o di dimensione moderata.

Scalabilità: prepararsi per sistemi in crescita

La scalabilità è fondamentale per i progetti che si espandono nel tempo.

Un sistema hardware scalabile consente di aumentare la capacità di elaborazione senza grandi interruzioni o riconfigurazioni.

Questo aspetto è particolarmente rilevante nell’apprendimento automatico e nel deep learning, dove i volumi di dati e la complessità dei modelli possono incrementare rapidamente.

Le soluzioni cloud, che offrono risorse di elaborazione aggiuntive su richiesta, sono molto flessibili e rappresentano una scelta comune per progetti che richiedono alta scalabilità.

Cloud vs Locale: qual è la soluzione più adeguata

Le soluzioni in cloud offrono flessibilità e scalabilità notevoli, permettendo agli utenti di accedere a risorse di calcolo potenti e aggiornate senza la necessità di investimenti iniziali pesanti in hardware.

Questo approccio è ideale per progetti che richiedono una rapida espansione della capacità di elaborazione o che hanno bisogno di ridurre i costi fissi.

Inoltre, il cloud facilita l’aggiornamento e la manutenzione dell’hardware, poiché i fornitori di servizi gestiscono queste operazioni, liberando tempo e risorse per l’innovazione e lo sviluppo del software di IA.

Le soluzioni locali, invece, offrono un controllo completo sull’hardware, il che è cruciale per le organizzazioni che gestiscono dati sensibili o hanno requisiti specifici di sicurezza e conformità.

Implementare l’hardware in loco permette alle aziende di mantenere una stretta supervisione sui loro sistemi e dati, riducendo i rischi associati alla trasmissione di informazioni sensibili attraverso la rete.

Tuttavia, l’hardware locale richiede un investimento capitale significativo, non solo per l’acquisto iniziale ma anche per la manutenzione e l’aggiornamento continuo dei sistemi.

La decisione quindi tra cloud e locale dipende da diversi fattori, inclusi il budget, la necessità di sicurezza dei dati, la flessibilità richiesta e la capacità interna di gestire l’infrastruttura IT.

Le organizzazioni che possono permettersi di gestire e mantenere la propria infrastruttura possono beneficiare della sicurezza e del controllo che l’hardware locale offre.

Al contrario, quelle che cercano una soluzione più scalabile e meno onerosa in termini di manutenzione potrebbero preferire il cloud.

Hardware per l’IA: Machine Learning

Il Machine Learning tradizionale utilizza una varietà di algoritmi, dai semplici ai più complessi, e la scelta dell’hardware giusto può variare notevolmente a seconda delle necessità computazionali.

Le CPU sono fondamentali negli ambienti di machine learning tradizionali, specialmente per gli algoritmi che non necessitano di un’intensa elaborazione parallela.

Modelli meno complessi, come la regressione lineare, gli alberi decisionali o i support vector machines, possono essere efficacemente allenati con le sole CPU.

Questo rende le CPU uno strumento versatile e conveniente per molti progetti di machine learning.

Sebbene le GPU siano spesso associate al deep learning, vengono impiegate anche nel machine learning tradizionale per accelerare l’elaborazione di grandi set di dati o per migliorare la velocità di algoritmi come il clustering k-means o la random forest.

La capacità delle GPU di gestire operazioni matriciali e vettoriali in modo efficiente le rende utili anche per questi scopi.

Le CPU sono particolarmente indicate per il machine learning tradizionale grazie alla loro capacità di gestire vari compiti senza richiedere una specializzazione e sono efficienti nell’eseguire algoritmi che richiedono una sequenza di operazioni o che non beneficiano di un parallelismo estensivo.

Quando invece gli algoritmi di machine learning tradizionale devono processare grandi quantità di dati o eseguire calcoli complessi, come l’inversione matriciale o operazioni intensive di clustering, le GPU possono ridurre significativamente i tempi di elaborazione, il che le rende preziose in scenari in cui la velocità è essenziale, anche al di là delle applicazioni di reti neurali.

Consideriamo un’azienda che utilizza l’analisi predittiva per ottimizzare le decisioni di gestione dell’inventario.

Utilizzando algoritmi come la regressione lineare o la foresta casuale, la CPU può essere sufficiente per analizzare dati storici di vendita e prevedere futuri pattern di acquisto.

Tuttavia, se l’azienda decide di estendere l’analisi includendo dati in tempo reale da molteplici fonti, l’aggiunta di GPU potrebbe essere necessaria per mantenere la velocità di elaborazione richiesta.

Hardware per l’IA: Deep Learning

Il deep learning, un ramo avanzato del machine learning, si distingue per l’utilizzo di reti neurali profonde che simulano il funzionamento del cervello umano attraverso architetture complesse.

Queste reti sono composte da numerosi strati di nodi di elaborazione e richiedono una quantità massiccia di operazioni matematiche, specialmente moltiplicazioni di matrici, che devono essere eseguite rapidamente e spesso in parallelo.

Le Graphics Processing Units (GPU), inizialmente sviluppate per il rendering grafico, sono diventate fondamentali nel deep learning per la loro capacità di gestire calcoli paralleli su larga scala.

Questa caratteristica permette alle GPU di processare centinaia di thread simultaneamente, rendendole ideali per l’allenamento di reti neurali che gestiscono milioni di parametri e operazioni contemporanee, riducendo drasticamente i tempi di training.

Le Tensor Processing Units (TPU), sviluppate da Google specificamente per il deep learning, sono ottimizzate per eseguire calcoli tensoriali più efficientemente rispetto alle GPU.

Questi dispositivi sono progettati per massimizzare la velocità e minimizzare il consumo energetico durante il training e l’inferenza, offrendo prestazioni superiori in task specifici grazie alla loro architettura personalizzata.

Ad esempio, nel settore automobilistico, il deep learning è utilizzato per sviluppare tecnologie di guida autonoma, addestrando reti neurali a riconoscere segnali stradali e altri elementi visivi dai dati delle telecamere.

L’uso di GPU e TPU permette l’elaborazione in tempo reale di grandi volumi di dati visivi, fondamentali per la sicurezza e l’efficienza di questi sistemi.

Nel campo medico, il deep learning aiuta nell’analisi di immagini diagnostiche, come radiografie e scansioni MRI, per identificare precocemente segni di malattie come il cancro.

Le GPU accelerano questo processo, consentendo diagnosi più rapide e accurate, mentre le TPU sono utilizzate per analizzare grandi dataset genomici, supportando i ricercatori nell’identificazione di pattern genetici legati a varie condizioni.

Anche le grandi aziende tecnologiche, come Google e Facebook, sfruttano le GPU e TPU per potenziare algoritmi di riconoscimento facciale, traduzione automatica e altri servizi basati sull’intelligenza artificiale che necessitano di un’intensa elaborazione in tempo reale.

Ma da dove partire?

Man mano che l’intelligenza artificiale si espande in vari settori, l’hardware dedicato deve evolversi per rispondere a esigenze sempre più complesse.

Recentemente, si è visto un aumento dell’interesse verso hardware specificamente progettato per l’IA, come le TPU e dispositivi simili, ottimizzati per specifiche funzioni di apprendimento automatico e deep learning.

Questi componenti promettono miglioramenti significativi in termini di velocità ed efficienza energetica.

Si prevede che l’adozione di questi chip specializzati crescerà, trovando spazio non solo nei grandi data center, ma anche in dispositivi consumer come smartphone e wearables.

Il computing neuromorfico, che si ispira all’architettura del cervello umano, sviluppa circuiti che emulano le reti neurali biologiche.

Questa tecnologia è destinata a rivoluzionare l’hardware per IA, offrendo soluzioni più efficienti in termini energetici e più rapide per gestire le operazioni degli algoritmi, ideali per applicazioni che richiedono elaborazioni in tempo reale e decisioni autonome, come nei robot mobili e nei dispositivi IoT.

Anche il quantum computing, sebbene ancora nelle sue fasi iniziali, promette di trasformare il campo dell’intelligenza artificiale.

Le proprietà quantistiche consentono di eseguire calcoli a velocità straordinarie, ideali per affrontare problemi complessi di ottimizzazione e simulazione che sfidano i computer tradizionali.

L’applicazione del quantum computing potrebbe generare innovazioni rivoluzionarie in settori come il drug discovery, la logistica e l’analisi finanziaria.

Con l’avanzamento delle tecniche di AI, è fondamentale che l’hardware non solo sia all’altezza delle sfide attuali, ma anche che anticipi le necessità future.

La scelta dell’hardware giusto dipenderà dagli obiettivi del progetto e dal tipo di modello di IA sviluppato.

A questo proposito, noi di DataDeep ci proponiamo come partner esperti, offrendo consulenze personalizzate progettate per integrarsi perfettamente con le esigenze specifiche della tua organizzazione.

Il nostro obiettivo è instaurare una cultura basata sull’apprendimento continuo e sull’orientamento strategico ai dati.

Ci impegniamo a trasferire conoscenze essenziali e competenze pratiche, fornendo alla tua organizzazione gli strumenti necessari per navigare con sicurezza nel contesto attuale e gestire efficacemente le sfide informative.

Per scoprire come possiamo contribuire al successo del tuo progetto di intelligenza artificiale, ti invitiamo a contattarci per uno studio di fattibilità gratuito.

In questa fase iniziale, collaboreremo per definire la strategia migliore per avviare il tuo progetto di IA, gettando le basi per un futuro guidato dai dati e dalla conoscenza approfondita.